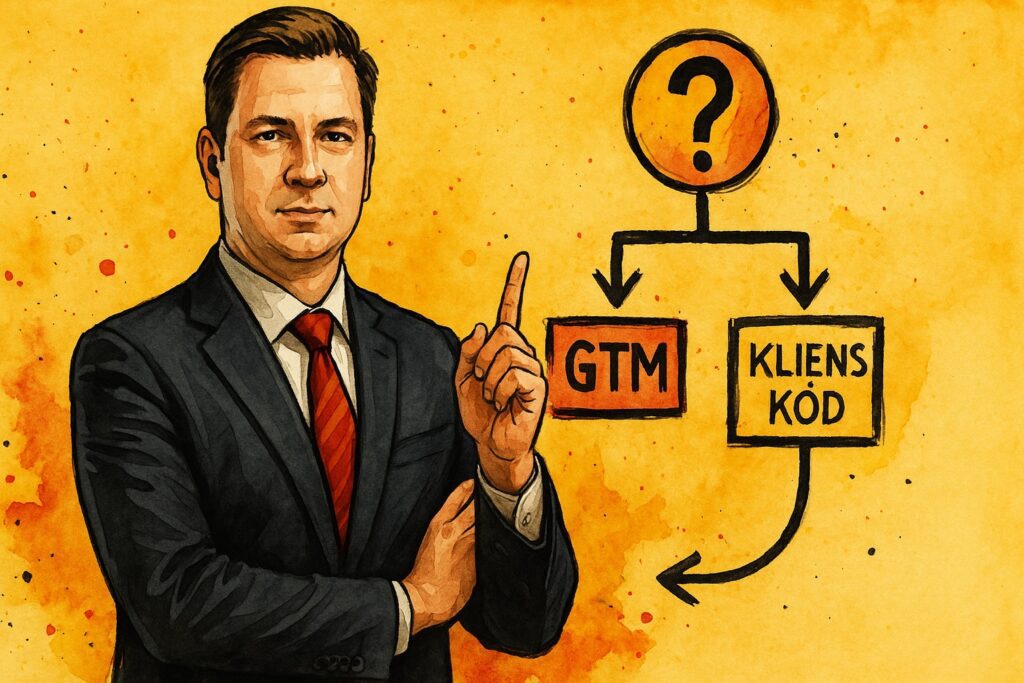

Az implementáció nem kódkérdés, hanem irányítás: milyen mérést engedünk be a rendszerbe, milyen költség és kockázat mellett, és milyen időtávon akarunk döntésképesek maradni. A „GTM vs. natív kód” és a „kliens- vs. szerveroldali taggelés” viták látszólag technikai részletekről szólnak, valójában arról, hogyan szervezzük a figyelmi rendszerünket egy olyan környezetben, ahol a böngészők szigorodnak, a felhasználók tudatosabbak, a jogi megfelelés kötelező, a hirdetési platformok pedig pontos jelet kérnek, különben rosszul tanulnak. A Google Tag Manager (GTM) gyorsaságot, verziózást és jogosultságkezelést ad; a natív (gtag.js vagy közvetlen SDK) telepítés minimális réteggel, stabilitással és kiszámítható teljesítménnyel csábít. A kliensoldali taggelés közel van a felhasználóhoz, ezért gazdag kontextust lát, viszont a böngésző és a bővítmények világában törékenyebb; a szerveroldali taggelés (GTM szerver konténerrel) fegyelmezettebb, első félként futó végponttal, kisebb kliens-terheléssel és jobb adatút-kontrollal dolgozik, de bevezetése költséget, DevOps-fegyelmet és döntéseket kér arról, mit alakítunk át és mit nem. Ebben a cikkben döntési fát adok, nem „szabálykönyvet”: a cél, hogy ugyannak az üzleti kérdésnek ne legyen háromféle technikai „megoldása”, hanem egy koherens, dokumentált rendje. Előbb kiválasztjuk a keretet (üzleti cél, kockázat, költség, csapat), utána rendezzük a GTM vs. natív dilemmát, majd a kliens vs. szerver döntést. Közben beszélek azokról az apróságokról, ahol a projektek tipikusan elcsúsznak: SPA-route kezelés, referral-kivételek, duplikált purchase, consent-jel útja, appverziók követése, deduplikáció a hirdetési rendszerek felé. Nem hiszem, hogy van univerzális válasz. Abban hiszek, hogy a jó implementáció olyan, mint egy jó főkönyv: kevesebb a szépség, több a fegyelem, és minden tételnek helye, célja, gazdája van. Ez a rend az, ami végül pénzt csinál a mérésből: gyorsabb döntés, kevésbé drága hibák, és a tanuló algoritmusoknak adott jobb jelminőség.

Döntési keret

Először a keret. A technikai megoldás választása előtt tisztázni kell, hogy mit optimalizálunk: időt a piacon, üzemeltetési kockázatot, költséget, adatkormányzást, jogi kitettséget vagy éppen a hirdetési rendszerek tanulásához szükséges jelminőséget. Tapasztalatom szerint érdemes egy egyoldalas „implementációs találati mátrixot” készíteni, ahol minden szempontnak súlyt adunk, majd ezt egy negyedévig változatlanul tartjuk. Az időnyomásos projektek (kampányindítás, szezon) hajlamosak a leggyorsabb, legkényelmesebb megoldást választani, ami rövid távon jó, hosszú távon drága. Ezzel szemben a fegyelmezett projektek a következő kérdésekkel kezdenek: 1) Mi a mérési stratégia (NSM/OMTM és guardrail-ek)? 2) Milyen azonosítási rendet tudunk konzisztensen működtetni (user_id, consent, cross-domain, app-linkek)? 3) Milyen tartós üzemeltetési kapacitásunk van (verziózás, monitoring, riasztás, naplózás)? 4) Milyen költségkeretet kap a szerveroldali infrastruktúra (felhő, CDN, üzemeltetés), és mi a „stop” jel, ha a költség elszalad? 5) Milyen a jogi kockázattűrés és milyen iparági szabályozás érint (pénzügy, egészség, gyermekek)? Ha ez megvan, a többi már pályaorientáció: a GTM akkor ad értelmet, ha verziózni és felügyelni akarunk; a natív akkor, ha stabil, ritkán változó, minimálisan függő mérést akarunk. A kliensoldali megoldás akkor racionális, ha a kontextus gazdagsága (UX-jelek, eszközszintű változók) többet ér, mint az elvesző jelek költsége; a szerveroldali akkor, ha hosszú távon minőségi és jogilag vállalható jelút kell (például deduplikált, pontosan időzített konverziós jel a hirdetési rendszerek felé, kisebb kliens-terheléssel). A döntési keret végén mindig legyen egy „nem tesszük” lista is: mit nem mérünk szándékosan (érzékeny adatok, kiskapuk), hogy a csapat ne csússzon el egy-egy „okos” ötlet mentén. Ezzel tartjuk egyenesben az etikát, az adatvédelmet és az üzemi fegyelmet – különben a technika szétfut és a riportok hitelüket vesztik.

| Szempont | GTM előny | Natív előny | Kockázat, ha rosszul választasz |

|---|---|---|---|

| Fejlesztési sebesség | Gyors kiadás, verziózás, előnézet | Kevesebb réteg, kisebb overhead | „Hotfix‑függőség” vagy lassú release‑ciklus |

| Adatkormányzás | Szerepkörök, naplózás, változáskövetés | Kódbázis‑fegyelem, code review | Átláthatatlan tulajdonosi mátrix vagy „shadow tags” |

| Teljesítmény | Kondicionális betöltés, késleltetés | Minimalista szállítás, kevesebb JS | CLS, FID romlás, mérési zaj |

| Diagnosztika | DebugView/Tag Assistant, riasztás | App/oldali logok, APM | Hosszú hibakeresés, „eltűnt jel” |

GTM vs. natív kód

A GTM a marketing‑ és termékcsapatok mozgásterét növeli: a címkék, triggerek és változók a konténerben élnek, a verziózás és az előnézet lehetővé teszi, hogy a kiadás kontrollált legyen, a hibát gyorsan visszafordítsuk, a jogosultság pedig finoman szabályozza, ki mit tehet. Ez akkor különösen hasznos, ha több csapat dolgozik ugyanazon tulajdonon, gyakoriak a kampányok és a kreatív‑tesztek, és a mérés folyamatosan fejlődik. A natív kód azért vonzó, mert nem adunk egy plusz réteget a kliensre: kisebb a függőség, kevesebb a futó JS, és a kódbázisban él minden szabály, ami egyes szervezeteknél jobban illeszkedik a code‑review kultúrához. A veszély mindkét oldalon ugyanaz: a rosszul tervezett GTM „matrjoska‑konténerré” nő (száz címke, egymásra csúszó triggerek, rejtett tesztkódok), a natív megoldás pedig „beég” a frontendre és minden apró változtatásnál release‑ciklushoz köt. Személyes gyakorlatom: ahol komoly a kampány‑ és kísérleti intenzitás, és több kompetencia dolgozik együtt, a GTM az alap (frontend‑ és backend‑review mellett). Ahol hosszú életciklusú, stabil mérést futtatunk kevés változással (például erősen szabályozott iparág, ritka kampány), ott a natív telepítés is racionális, feltéve, hogy a verziózás, logolás és rollback fegyelme megvan. Fontos különbség: a GTM nem mentesít a mérési terv és az adatréteg szerződés alól. Ha nincs közös nevezéktan (esemény/paraméter), a konténer csak gyorsabban szállítja a káoszt. És fordítva: a natív telepítés sem lesz „önmagában tiszta”, ha a kód mellé nincs dokumentáció és kiadási napló. A döntés tehát nem ideológia: a szervezeti ritmus és a várható változásmennyiség mondja meg, melyik út kevesebb összköltséget és jobb jelminőséget ad egy éven belül. Kiegészítésként érdemes megemlíteni a hibrid modellt: a kritikus, ritkán változó részek natívban (például purchase‑jel és dedup kulcs), a dinamikus kísérletek GTM‑ben (például tartalom‑csoport, scroll, video milestone). Ezzel a felelősség együtt marad az IRL ritmussal: ami „kő”, az kódban él, ami „homok”, az GTM‑ben, dokumentált határvonal mellett.

| Helyzet | Ajánlott | Miért | Mit kerülj |

|---|---|---|---|

| Gyakori kampány‑ és kísérleti ciklus | GTM | Gyors kiadás, rugalmas triggerelés | „Ideiglenes” címkék elfelejtett törlése |

| Szabályozott iparág, ritka változás | Natív + minimális GTM | Kisebb felület, code‑review erős | GTM‑függőség feleslegesen |

| Hibrid csapat (marketing + termék) | Vegyes | Felelősség a ritmushoz igazítva | „Minden GTM‑ben” vagy „minden kódban” dogma |

Kliensoldali taggelés

A kliensoldali taggelés a weben és az appban közvetlenül a felhasználó eszközén fut: látja a felület finom rezdüléseit (scroll, interakciók), hozzáfér a böngésző kontextusához, és valós időben képez jeleket. Előnye a gazdag kontextus és az egyszerű telepítés; ára a törékenység és a zaj. A weben a nagy ellenség az aszinkronitás és a változó környezet: SPA‑k esetén a route‑váltások nem generálnak természetes page_view‑t, ezért a kézi jelölés kötelező; a payment‑gateway‑k (külső domainek) referral‑szennyezést okoznak, ha nincs kivétel; a böngésző‑kiterjesztések és a tartalomblokkolók egyes címkéket letilthatnak; a consent‑jel érkezésének időzítése dönti el, hogy az első oldalbetöltés „milyen jogállapotban” mér. A mobilban más a gravitáció: screen_view van page_view helyett, az app életciklusa (háttérbe kerülés, offline pufferelés, késleltetett küldés) stabil eseményküldést kér, és az OS‑szintű korlátozásokhoz kell igazítani az engedélykérést. A kliensoldal ereje ott jön ki, ahol UX‑szintű diagnosztikára és kontextusra van szükség (például scroll‑mélység és cikk‑befejezés tartalmi oldalon; form‑hibák és hibaüzenetek e‑kereskedelemben; rezdülések, amelyek segítenek priorizálni a fejlesztési backlogot). A hátránya is itt épül: minél több eseményt és paramétert küldünk, annál zavarosabb lesz az elemzés, annál drágább a warehouse‑oldali feldolgozás, és annál nagyobb az esély az adatvédelmi hibára. A jó kliensoldali implementáció ezért nem „minél több jel”, hanem „minél hasznosabb jel”: három réteg (alap, tölcsér, érték), gondos névkonvenció, duplikáció‑védelem (transaction_id/event_id), és szigorú QA (DebugView, tesztvásárlás, route‑figyelés, referral‑ellenőrzés). A hirdetési rendszerek felé menő kliensoldali jelek esetén kulcs az időzítés és a dedup: ha egy purchase egyszerre megy GA4‑be és Ads‑be kliensoldalról és szerveroldalról is, akkor csak egy maradhat „elsődleges”. Itt bukik el a legtöbb mérés: nem a platform „rossz”, hanem a jelrendszer következetlen. Végül: a kliensoldal kényes a teljesítményre. A „mindent mérünk” mindset könnyen rontja a betöltési mutatókat, ami SEO‑ban és konverzióban is fáj. Inkább kevesebb, de tisztább jel – és amit a kliens nehezen visz, azt a szerver vegye át.

- Kliensoldali jó gyakorlat: SPA‑route kézi jelölés; referral‑kivételek; consent‑jel előbb a tageknél; purchase‑dedup; kevés, cél‑vezérelt paraméter; DebugView‑alapú kiadási rituálé.

Szerveroldali taggelés

A szerveroldali taggelés lényege, hogy a mérést és a hirdetési jelzéseket egy saját, első félként futó végponton (például collect.brand.hu) vesszük át, ott átalakítjuk, tisztítjuk, esetleg bővítjük meta‑információval, majd továbbítjuk a célrendszerek felé. A legnagyobb előny a kontroll: a kliens kevesebb kódot futtat, a böngésző felé kevesebb harmadik feles hívást indítunk, a jelek pedig stabil, kiszámítható csatornán mennek. Előny még, hogy a különböző forrásokból (web, app, backend‑tranzakciók) érkező eseményeket egységesíthetjük (például ugyanaz a transaction_id logikája él mindenhol), a deduplikációt a szerveren intézhetjük, és a továbbítás sorrendjét/idejét pontosabban kezelhetjük. A valóság azonban nem csupa nyereség. A szerveroldal DevOps‑fegyelmet kér (felhőerőforrások, skálázás, naplózás, költségfigyelés), és döntéseket arról, hogy mit alakítunk át és mit nem. Szigorúan tartom: szerveroldalon sem küldünk személyes adatot engedély nélkül; a hozzájárulás hiányát nem „jogi trükközéssel”, hanem üzemi fegyelemmel kezeljük (Advanced Consent Mode cookieless ping + modellezés). A szerveroldal egyik buktatója a „varázsdoboz” hatás: ha a csapat nem lát bele, mi történik a végponton, gyorsan elveszik a bizalom. Ezt csak jó dokumentáció és transzparens naplózás gyógyítja. Költség szempontból a szerveroldal nem ingyenes: a forgalommal nő a felhőszámla és az üzemeltetési teher. Az én tapasztalatom: ahol jelentős a hirdetési költés, fontos a jelminőség (dedup, időzítés, rendszerközi egység), és számít a kliens‑teljesítmény, ott a szerveroldal ára rövid távon is megtérül az algoritmusok jobb tanulása és a stabil attribúció miatt. Ahol kicsi a költés, ritka a változás és szűk a csapat, ott a kliensoldali fegyelmezett megvalósítás bőven elég. A szerveroldal akkor csillog, ha a döntési kérdés ez: „kisebb kliens‑terheléssel, jobb jel‑minőséggel és átláthatóbb adatúttal akarunk‑e működni, vagy maradunk a gyors kiadásnál és többet költünk a diagnosztikára?” Ha az első a válasz, érdemes belevágni, de csak lépésenként: először egyetlen üzletkritikus jel utazik szerveroldalon (például purchase dedup Ads/Analytics felé), aztán jöhetnek a többiek. Így épül ki fájdalom nélkül a fegyelem – és nem borítjuk fel a napi operációt.

| Előny | Mit ad | Ár/kompromisszum | Mit figyelj |

|---|---|---|---|

| Első fél végpont | Kevesebb blokkolás, stabil út | DNS/SSL, infra, monitoring | Hiba‑események és fallback |

| Dedup és időzítés | Pontos konverzió‑jel a platformoknak | Implementációs munka | Transaction_id/event_id fegyelem |

| Egységesítés | Web/app/backend egy séma | Szabálykarbantartás | Verziózás és naplózás |

| Kliens teher csökken | Gyorsabb oldal, jobb UX | Felhőköltség nőhet | Költségfalak, kvóták |

Döntési fa

Az alábbi fa nem „szabály”, hanem működő kiindulópont. Lépj végig rajta, és minden ág végén kapni fogsz egy implementációs mintát: GTM‑orientált, natív‑orientált, kliens‑központú vagy szerver‑támogatott. 1) Változásritmus: ha havi/gyakoribb kampány‑ és kísérleti ciklusod van, indulj GTM‑mel; ha negyedévesnél ritkább, maradhat natív. 2) Jog és iparág: ha az iparág érzékeny (pénzügy, egészség, gyermek), korlátozd a kliensoldali réteget a minimumra; kritikus jeleket vidd backend/szerveroldalra; mindenhol tartsd szigorúan a hozzájárulást. 3) Azonosítás: ha van stabil user_id és vállalható hozzájárulási arány, szerveroldalra tudsz építeni hosszú távú attribúciót; ha nincs, maradj kliensoldali fegyelemben és építsd fel az azonosítási rendet. 4) Hirdetési költés: ha jelentős és az algoritmusok jelminőségtől függenek, vigyél át legalább egy konverziós jelet szerveroldalra (dedup + időzítés), a többire fokozatos átállás; ha alacsony, kliensoldal elég. 5) Csapat és üzemeltetés: ha van DevOps‑kapacitás, nyiss szerveroldal felé; ha nincs, ne tedd az analitikát rendszergazda‑problémává – GTM‑fegyelem, kevesebb jel, jobb dokumentáció. 6) Teljesítmény: ha a betöltési mutatók gyengék és sok a címke, használj szerveroldalt a harmadik feles hívások kiváltására; ha jók a mutatók, ne változtass csak „trend” miatt. A fa végén mindig dokumentálj: mely jelek maradnak kliensen (UX, finom interakciók), melyek mennek szerveren (konverzió, dedup, költségkapcsolat), és hol a felelősségi határ. Így nem csak technikát választasz, hanem irányítási rendet is. Ezt a rendet írd alá a csapattal: ha közben kiderül, hogy rossz volt egy ág, visszafordulsz – de naplóval, nem emlékezetből. Ez az a különbség, amelyik egy kampányok között rohanó csapatot működő, visszatanuló szervezetté tesz. A döntési fa végén pedig jöhet a migráció: dual‑run (régi+új jel együtt), kontrollmérés, és csak eredmény után a régi kapcsolók le.

| Szcenárió | Ajánlott megoldás | Első lépés | Mit mérj előtte/utána |

|---|---|---|---|

| Gyors kampányindítás, több csapat | GTM + kliensoldal | Mérési terv + GTM release rituálé | PageSpeed, DebugView tisztaság, purchase duplikáció |

| Nagy költés, jelminőség kritikus | Hibrid + szerveroldali konverzió | Purchase dedup szerveren, Ads/GA4 összhang | Dedup arány, attribúciós stabilitás |

| Szabályozott iparág, ritka változás | Natív + szerveroldali alapjelek | Consent út dokumentálása, minimál kliens | Consent arány, jogi audit nyomvonal |

| App‑központú termék | SDK + szerveroldali egységesítés | Verziózás, event‑szótár összehangolás | Screen_view konzisztencia, offline puffer |

Migráció és üzemeltetés

A döntés csak az első mérföldkő. A következő a migráció: nem egy nap alatt történik, és nem „big bang” jelleggel. Indíts dual‑runnal: a régi és az új jel egy ideig együtt él, kontrollált mintában. Közben adj riasztást a fő eseményekre (purchase, lead, begin_checkout), a consent arányra és az ismeretlen referral ugrására. A „kliens→szerver” átállásnál először a konverziós jelet vidd át (dedup, időzítés, Ads/Analytics logika összehangolása), utána jöhetnek a kísérleti címkék. Dokumentáld külön, hogy melyik platformon melyik jel az elsődleges forrás (például Ads: szerver; GA4: kliens), hogy a későbbi vitákat megelőzd. A warehouse‑kapcsolatnál építs „golden datasetet”: deduplált rendelés/lead, egységes csatornaszabályok, consent arány naplózva – különben az idősoraid időről időre „megugranak”, és a vezetői riportok újra vitaképesek, de nem döntésképesek lesznek. Az üzemeltetés mindennapjaihoz tartozik a kiadási rituálé: DebugView/Tag Assistant ellenőrzés, route‑próba, tranzakció‑szimuláció, rollback‑terv. Ezt a rituálét nem lehet átugrani – az a 30 perc, amit itt eltöltesz, napokat spórol meg egy hibás release után. Végül: tanulj vissza. Ha szerveroldalra váltottál, mérd, hogy a kliens‑teljesítmény, a konverziós költség és az attribúciós stabilitás hogyan változott. Ha nem hoz érdemi nyereséget, állj meg és optimalizálj; ha hoz, jöhet a következő jel. Ez a fokozatosság tartja életben a csapat bizalmát és a vezetői türelmet – és ebből lesz a hosszú távú, fenntartható méréspolitika.

Migrációs ütemterv: dual‑run, dedup, platform‑szinkron

A szervezetek többsége nem új lapon indul, hanem élő rendszer mellé épít új jelutat. A migráció ezért nem „big bang”, hanem fegyelmezett párhuzamos futás (dual‑run), amelynek célja, hogy a döntések egyetlen napon se maradjanak jel nélkül, és közben kiderüljön, mit ad ténylegesen az új architektúra. A menetrend nálam négylépéses. 1) Előkészítés: mérési terv frissítése (esemény‑ és paraméterszótár, user_property‑k), consent‑út dokumentálása (CMP → GTM/gtag → tagek), referer‑kivételek és cross‑domain lista rendezése, purchase/lead dedup‑kulcs rögzítése (transaction_id, event_id, lead_id). 2) Dual‑run kontrollmintán: a régi kliensoldali jel marad elsődleges, mellé bekötjük az új (például szerveroldali) jelutat; a kulcs az, hogy a két forrást nem terítjük szét azonnal a teljes forgalomra, hanem jól körülhatárolt szegmensre (például 10–20% random, vagy egy kisebb geó) futtatjuk, és előre megnevezett mutatók mentén hasonlítjuk össze (attribúciós stabilitás, konverziós költség, kliens teljesítmény, „ismeretlen referral” arány). 3) Elsődleges forrásváltás csak akkor, ha a dual‑run eredménye egyértelmű: platformonként kijelöljük, hol legyen a szerveroldali jel az elsődleges (például Google Ads – szerveroldali; GA4 – kliens vagy hibrid), és ezt írásban a mérési terv részeként rögzítjük. 4) Teljes kiterjesztés és „régi kapcsolók” lekapcsolása: csak a visszalövés (kontrollmérés) és a riasztási időszak után kapcsoljuk ki a régi csatornát; a „mindenki egyszerre” átállásokból lesz a legtöbb adatmegtörés. A dual‑run igazi értéke nem a szépség, hanem a visszamérhetőség: látjuk, hogy a dedup hogyan működik, a jelek időzítése mennyivel lesz pontosabb, a platformok tanulása mennyire stabil. Az alábbi táblázat a fő lépések és ellenőrzési pontok rövid összefoglalója; ez kerül nálam a release‑jegyzőkönyv elejére, mert így egy oldalon látszik, miért és hogyan futunk párhuzamosan, meddig, és mi a „go/no‑go” kritérium. Aki ezen spórol, később a riportokon fizet kamatot: a kettős jelzésből lesznek az elcsúszott idősorok és a „miért nőtt hirtelen az a csatorna?” típusú értelmetlen viták.

| Szakasz | Teendő | Ellenőrzés | „Go/No‑go” jel |

|---|---|---|---|

| Előkészítés | Mérési terv, consent‑út, dedup‑kulcsok, referer‑kivételek | DebugView, Tag Assistant, tesztvásárlás/lead | Hiba nélküli tesztfutás, tiszta paraméterezés |

| Dual‑run (10–20%) | Régi + új jel párhuzamosan kontrollmintán | Attribúciós stabilitás, dedup arány, oldal‑teljesítmény | ±5%‑on belüli eltérés vagy indokolt különbség |

| Elsődleges forrásváltás | Platformonként kijelölt elsődleges jel | Riasztás 72 órára; anomáliafigyelés | Nincs váratlan esés/tüske a fő mutatókon |

| Teljes kiterjesztés | Régi jel lekapcsolása, naplózás | Heti audit: ismeretlen referral, consent arány, költség‑jel | Tiszta idősor, stabil tanulás |

Consent Mode integráció és időzítés a gyakorlatban

A hozzájárulási jel időzítése azon kevés részlet egyike, amely képes teljes tölcsért torzítani – és emiatt nálam van kiemelt helyen a migrációs ütemtervben. A helyes sorrend egyszerű, mégis gyakran borul: 1) a CMP jelenik meg elsőnek; 2) a döntés azonnal átmegy a GTM/gtag felé (Consent Initialization, default = denied); 3) a felhasználó választása után jön az update (granted/denied) oldalváltás előtt; 4) csak ezután kezdhetnek el dolgozni a tagek úgy, hogy a választást tiszteletben tartják (Basic/Advanced mód). Ha ez egyetlen helyen késik – például az első kampánylandoláson nincs update –, a munkamenet forrása, az attribúció és a modell‑arány is csúszni fog. A migrációnál ezért nem csak azt nézzük, hogy megy‑e a jel, hanem azt is, hogy mikor. Haladó megoldásként az Advanced módot preferálom, mert a cookieless pingek a modellezéshez életben tartják a döntéshez igazított, de nem azonosító jelzést; ez gyakran különbséget jelent a platformok tanulásában. A bevezetés kérlelhetetlenül fegyelemhez kötött: a default státusz mindig denied, a frissítés mindig a kattintás pillanatában történik, a diagnosztika pedig mindig

Dedup és platformszinkron: kulcsok, elsődleges jel, ütközések

A deduplikáció nélkül a szerveroldal csak „még egy cső”. A migrációnál először tisztázzuk, mi lesz a kulcs (transaction_id/lead_id/event_id), mely platform melyik jelutat tekinti elsődlegesnek, és hogyan kezeljük az ütközést (amikor ugyanarra az eseményre kliens‑ és szerveroldalról is érkezik jel). GA4‑ben a transaction_id jól bevált, de szigorú következetesség kell: ugyanaz az azonosító jöjjön webből, appból és Measurement Protocolból; a lead világban ugyanez a lead_id. Google Ads felé el kell dönteni, hogy a konverzió elsődlegesen melyik csatornán érkezik (jellemzően szerveroldalon, mert stabilabb és időzíthetőbb), és hogyan jelöljük a kliensoldali párt (másodlagos, csak ellenőrzésre). Az ütközés nem elmélet: a platformoknak meg kell mondani, mikor tekintsenek két jelre egy eseményként (dedup), és mikor kettőnek (dupla számítás tilos). Ebben a világos kulcs és az időablak segít (például 72 órán belüli duplák kizárása). A szerveroldali végpontnál a „továbblökés” (forwarding) is új felelősség: ha a konverzió nem áll össze (hiányzó kulcs, tiltott mező, consent = denied), nem továbbítunk ok nélkül; a napló pedig kimondja, miért. A gyakorlat lefordítható egy rövid, asztali táblára, amit minden release előtt ellenőrzünk. Ha ez a tábla nincs, dedup‑kumulatív hibát gyártunk: hetente kicsit több a jel, a negyedév végére már más a valóság, mint a riport. Ezen a ponton nem a technika, hanem a következetesség nyer pénzt: az algoritmusnak adott egy pontos jel többet ér, mint kettő bizonytalan.

| Platform | Kulcs | Elsődleges jelút | Dedup logika | Megjegyzés |

|---|---|---|---|---|

| GA4 | transaction_id / event_id | Kliens (alapeset) + MP „összefűzés” | Azonos kulcs esetén egyszer számol | MP csak kiegészítés, nem duplikáció |

| Google Ads | order_id / gclid / wbraid/gbraid | Szerveroldali (ajánlott) | Azonos order_id és click id → egyszer számol | Kliensoldali jel másodlagos ellenőrzés |

| Meta (CAPI) | event_id / email hash | Szerveroldali | event_id egyezés → dedup | Időablak rögzítve (pl. 72 óra) |

Költség és teljesítmény: TCO, jelminőség, megtérülés

A döntés végső soron költség‑haszon mérleg. A kliensoldal „olcsóbbnak” tűnik, de teljesítményben és hibajavításban drága lehet; a szerveroldal „költségesebbnek” látszik (felhő, üzemeltetés), mégis megtérülhet az algoritmusok jobb tanulása, a gyorsabb oldalak és a diagnosztikai átláthatóság miatt. A tiszta mérleghez TCO‑ban gondolkodjunk: bevezetési költség (mérési terv, fejlesztés, infra), üzemeltetés (felhő, monitoring, riasztás), diagnosztika (hibakeresés, visszaállítás), és „rejtett” hatás (oldalbetöltési idők, kampány‑tanulás). A szerveroldalnál a legnagyobb – és legtöbbet vitatott – sor a felhőköltség. Én ezt két lépéssel kezelem: 1) kvóták és riasztások (ha a forgalom vagy a költség ugrik, tudjunk róla aznap), 2) fokozatos átállás (először csak purchase/lead, aztán a többi), hogy a kapacitás ne „robbanjon”. A megtérülésnél nem a „szép grafikon” a cél, hanem három kemény mutató: attribúciós stabilitás (kevesebb ugrás ugyanazon kampánynál), konverziós költség (jelminőség hatása a CPA‑ra), oldal‑teljesítmény (LCP, INP javulása). Az alábbi tábla ilyen TCO‑nézetet ad. Nem helyettesít pénzügyet, de ráteszi az érveket egy tiszta lapra. Általában már ez a gyakorlat húzza ki a vitából a levegőt: amikor a csapat látja, hogy a szerveroldal nem „divat”, hanem konkrét költség és konkrét nyereség, könnyebb dönteni – sőt, könnyebb visszafordulni is, ha a számok nem hozzák a várt eredményt.

| Tétel | Kliens‑központú | Szerver‑támogatott | Megjegyzés |

|---|---|---|---|

| Bevezetés | Alacsony–közepes (GTM, kód) | Közepes–magas (infra + fejlesztés) | Fokozatos átállással simítható |

| Üzemeltetés | Alacsony látható, magas rejtett (hibakeresés) | Közepes (felhő, monitoring), alacsony rejtett | Transzparens napló csökkenti a rejtett költséget |

| Oldal‑teljesítmény | Gyakran romlik (sok címke) | Javul (kevesebb klienshívás) | SEO/UX mellékhatás |

| Jelminőség | Ingadozó (blokkolás, időzítés) | Stabilabb (időzítés, dedup) | Algoritmusok gyorsabban tanulnak |

Szerveroldali debug és naplózás: láthatóvá tenni az „átfolyást”

A szerveroldal szépsége – és kockázata – a láthatatlanság. Ha nincs fegyelmezett naplózás, egy hét után senki sem tudja, milyen transzformációk futnak, hol akadt el egy jel, vagy miért nőtt meg a költség. Az üzembe helyezés része ezért a teljes út logolása: bejövő kérés (header, consent állapot, payload kivonat), transzformációk (milyen szabályokat alkalmaztunk, mely mezőket vágunk/anonimizálunk), üzleti döntések (továbbítás igen/nem és miért), kimenő válasz (célrendszer, státusz, késleltetés), hiba‑események (4xx/5xx), és költség‑jelentések (kérésszám, CPU/GB‑másodperc, kvóta közeli állapot). A naplót nem „mentjük valahová”, hanem felügyeljük: riasztás megy például dedup‑arány változására, célrendszer‑válaszkésésre, hibaarány megugrására, és az ismeretlen forrásból jövő kérésekre. A debugnak két oldala van. Kliens‑szinten a Tag Assistant és a DebugView adja a „mi ment ki?” képet; itt kiderül, mikor jön a consent update, milyen paraméterek mennek, és mi indul el korán/későn. Szerver‑szinten a validáció és a szemcsés napló mutatja meg, hogy a szerver mit kapott, mit fogadott el, mit dobott vissza és miért. Mindezt kiegészíti a „szárazföldi” teszt: szintetikus vásárlás/lead a stagingben, három böngészőn, két hálózaton, rögzített időbélyeggel; ha itt jó, akkor mehet élesbe. A debug kultúrának van egy puha hatása is: a fejlesztés és a marketing kevesebbet vitatkozik, mert ugyanazt a képernyőt nézik. Ez nem csak kényelmesebb – olcsóbb is. Az átállás utáni első hetek sikere nem azon múlik, hány címke futott át a szerveren, hanem azon, hogy mennyire látjátok, mi történik. Ha látjátok, gyorsan javítotok; ha nem, magyaráztok. És a magyarázat nem növeli a konverziót.

Runbook és üzemeltetési rituálé: ki, mikor, mit csinál

Az implementáció végén a rendszer akkor lesz stabil, ha a csapat tudja, kinek mi a dolga egy átálláskor, egy hiba esetén vagy egy negyedéves tisztogatáskor. A runbook ezért nem „szép dokumentum”, hanem műszakfüzet: rövid lépések, felelősök, időbélyegek. Indító blokk: változáskérelem (mi, miért, mikor), mérési terv módosítás, staging kiadás, DebugView/Tag Assistant ellenőrzés, consent smoke test, riasztási küszöbök aktiválása. Kiadás: ablak (mikor), visszavonási terv (melyik verzióra, ki csinálja), egyértelmű „elsődleges jel” kiosztás platformonként. Hiba: egysoros incidens‑csatorna (mi állt meg), elsősegély (átmeneti visszavonás vagy konténer rollback), okkeresés (napi logok, anomália grafikon), javítás, záró memo (mi volt, mit tanultunk, mit állítunk be, hogy ne ismétlődjön). Rutin: havi audit (belső/fejlesztői forgalom szűrése, csatorna‑csoportosítás ellenőrzése, dedup arány), negyedéves „takarítás” (GTM címkék, amelyek 60 napja nem lőttek, mennek a karanténba; szerveroldali transzformációk, amelyekhez nincs forgalom, törlésre jelölve), éves hozzáférés‑átvilágítás (Admin/Editor szerepkörök, 2FA, ügynökségek offboardingja). Ezek a rutinkörök unalmasnak tűnnek, de ők tartják össze a rendszert. Ha hiányoznak, a jelminőség szétesik; ha megvannak, a migráció csak egyszeri feladat volt – és onnantól egy karbantartható, visszatanuló jelrendszered van. Ezt a munkát nem lehet kiszervezni a „jövő énemnek”: minden release előtt van egy minimál checklista, és minden negyedévben van egy minimál megbeszélés. Röviden: a fegyelem a skálázhatóság ára. És megéri, mert a skála nem csak több adat, hanem több hasznos adat, amihez vissza is tudsz nyúlni, amikor dönteni kell.

Dajka Gábor marketingszakértő, business coach és befektető szerint

A GTM vs. natív, kliens vs. szerver vita valójában arról szól, mennyire vagyunk hajlandók fegyelmet vinni a jelek világába. A rövid út mindig a kliens: gyors, kényelmes, és látszólag ingyenes – amíg a böngészők és a bővítmények el nem kezdenek „szavazni”. A hosszabb út a szerver: tervezést, dokumentációt, üzemeltetést kér, de cserébe olyan jelt ad a rendszereknek, amelyre lehet stratégiát építeni. Én a kevert modellt szeretem: ami kő, menjen kódba vagy szerverre; ami homok, maradjon GTM‑ben – és ezt írjuk le egy oldalon. A döntést nem ideológia, hanem TCO és jelminőség dönti el. A félreértés nélküli mérés nem dísz, hanem működési előny: gyorsabb döntés, kevesebb tüske az idősorokban, olcsóbb optimalizálás. A szervezet ettől nem csak „adatvezérelt” lesz, hanem nyugodtabb is: a riportok mögött nem magyarázat áll, hanem bizonyíték. És ez a béke az, ami egy szezonban különbséget tesz. Nem kell szentté avatni a szerveroldalt, és nem kell száműzni a klienst. Elég, ha a csapat megérti: a mérés nem varázslat, hanem könyvelés. Ha minden tételt ugyanazon a nyelven és rendben viszünk fel, a végén lesz egy főkönyvünk, amihez hozzá lehet nyúlni. Ennyi elég is. A többi már munka – és szerencsére abból jól állunk.

Források:

Google Tag Platform – Server‑side tagging (GTM szerver konténer)

Google Tag Platform – Consent Mode v2: beállítás és hibaelhárítás

Google Analytics 4 – Measurement Protocol (szerver‑oldali/ offline események)